@小米技術 官微今日發文稱,小米大模型團隊在音頻推理領域取得突破性進展。受 DeepSeek-R1 啟發,團隊率先將強化學習算法應用于多模態音頻理解任務,僅用一周時間便以 64.5% 的 SOTA 準確率登頂國際權威的 MMAU 音頻理解評測榜首,現同步開源。

IT之家附官方全文如下:

強化學習展現“反直覺”優勢 —— 小米大模型團隊登頂音頻推理 MMAU 榜

面對一段汽車行駛中的座艙錄音,AI 能否判斷出汽車是否存在潛在的故障?在交響樂演出現場,AI 能否推測出作曲家創造這首音樂時的心情?在早高峰地鐵站混亂的腳步聲潮中,AI 能否預判閘機口可能發生的沖撞風險?在大模型時代,人們已經不滿足于機器僅僅識別說話的內容、聲音的種類,更期望機器具備復雜推理的能力。

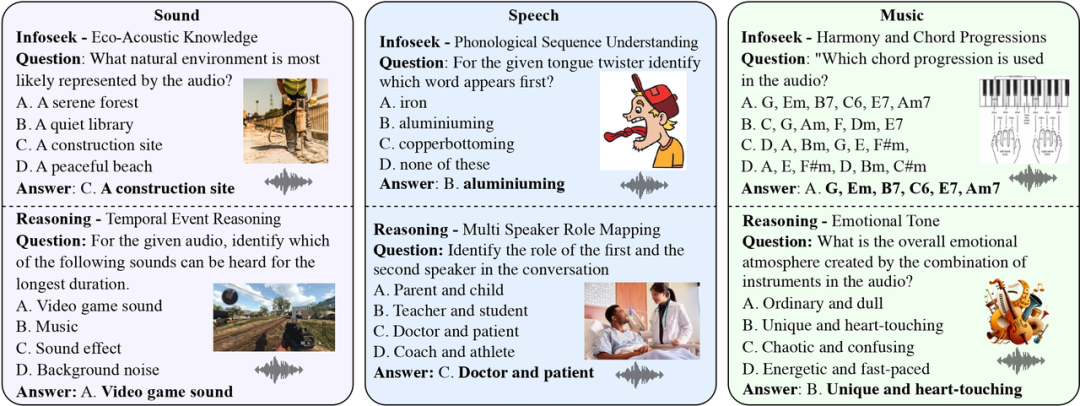

MMAU(Massive Multi-Task Audio Understanding and Reasoning)評測集(https://arxiv.org/abs / 2410.19168)是這種音頻推理能力的量化標尺,它通過一萬條涵蓋語音、環境聲和音樂的音頻樣本,結合人類專家標注的問答對,測試模型在 27 種技能,如跨場景推理、專業知識等應用上的表現,期望模型達到接近人類專家的邏輯分析水平。

作為基準上限,人類專家在 MMAU 上的準確率為 82.23%。這是一個很難的評測集,目前 MMAU 官網榜單上表現最好的模型是來自 OpenAI 的 GPT-4o,準確率為 57.3%。緊隨其后的是來自 Google DeepMind 的 Gemini 2.0 Flash,準確率為 55.6%。

MMAU 任務示例圖片來自 MMAU 論文

來自阿里的 Qwen2-Audio-7B 模型在此評測集上的準確率為 49.2%。由于它的開源特性,我們嘗試使用一個較小的數據集,清華大學發布的 AVQA 數據集(https://mn.cs.tsinghua.edu.cn/avqa/),對此模型做微調。AVQA 數據集僅包含 3.8 萬條訓練樣本,通過全量有監督微調(SFT),模型在 MMAU 上的準確率提升到了 51.8%。這并不是一個特別顯著的提升。

DeepSeek-R1 的發布為我們在該項任務上的研究帶來了啟發。DeepSeek-R1 的 Group Relative Policy Optimization (GRPO) 方法,讓模型僅通過 "試錯-獎勵" 機制就能使自主進化,涌現出類似人類的反思、多步驗證等推理能力。在同一時間,卡內基梅隆大學發布的論文預印本“All Roads Lead to Likelihood: The Value of Reinforcement Learning in Fine-Tuning (https://arxiv.org/abs / 2503.01067) ”,通過精巧的實驗得出了一個有趣的論斷:當任務存在明顯的生成-驗證差距(Generation-Verification Gap),即任務生成結果的難度遠大于驗證結果正確性的難度時,強化學習比起有監督微調具有獨特優勢,而 AQA 任務恰好是完美的生成-驗證差距顯著的任務。

打個比方來說,離線微調方法,如 SFT,有點像背題庫,你只能根據已有的題目和答案訓練,但遇到新題可能不會做;而強化學習方法,如 GRPO,像老師在要求你多想幾個答案,然后老師告訴你哪一個答案好,讓你主動思考,激發出自身的能力,而不是被“填鴨式”教學。當然,如果訓練量足夠,比如有學生愿意花很多年的時間來死記硬背題庫,也許最終也能達到不錯的效果,但效率太低,浪費太多時間。而主動思考,更容易快速地達到舉一反三的效果。強化學習的實時反饋可能會幫助模型更快鎖定高質量答案的分布區域,而離線方法需要遍歷整個可能性空間,效率要低得多。

基于上述洞察,我們嘗試將 DeepSeek-R1 的 GRPO 算法遷移到 Qwen2-Audio-7B 模型上。令人驚喜的是,在僅使用 AVQA 的 3.8 萬條訓練樣本的情況下,強化學習微調后的模型在 MMAU 評測集上實現了 64.5% 的準確率,這一成績比目前榜單上第一名的商業閉源模型 GPT-4o 有近 10 個百分點的優勢。

有趣的是,當我們在訓練中強制要求模型輸出

我們的實驗揭示了幾個和傳統認知不同的結論:

關于微調方法:強化學習在 3.8 萬條數據集上的表現顯著超過監督學習在 57 萬條數據集上的結果

關于參數規模:相比千億級模型,7B 參數的模型通過強化學習也可展現強推理能力

關于隱式推理:顯式思維鏈輸出反而成為性能瓶頸

盡管當前準確率已突破 64%,但距離人類專家 82% 的水平仍有差距。在我們當前的實驗中,強化學習策略還是比較粗糙,訓練過程對思維鏈的引導并不充分,我們會在后續做進一步探索。

此次實驗驗證了強化學習在音頻推理領域的獨特價值,也為后續研究打開了一扇新的大門。當機器不僅能 "聽見" 聲音,還能 "聽懂" 聲音背后的因果邏輯時,真正的智能聽覺時代將會來臨。

我們把訓練代碼、模型參數開源,并提供了技術報告,供學術界產業界參考交流。

訓練代碼:https://github.com/xiaomi-research/r1-aqa

模型參數:https://huggingface.co/mispeech/r1-aqa

技術報告:https://arxiv.org/abs/2503.11197