英偉達在今日舉行的 NVIDIA GTC 2025 上宣布其 NVIDIA Blackwell DGX 系統創下 DeepSeek-R1 大模型推理性能的世界紀錄。

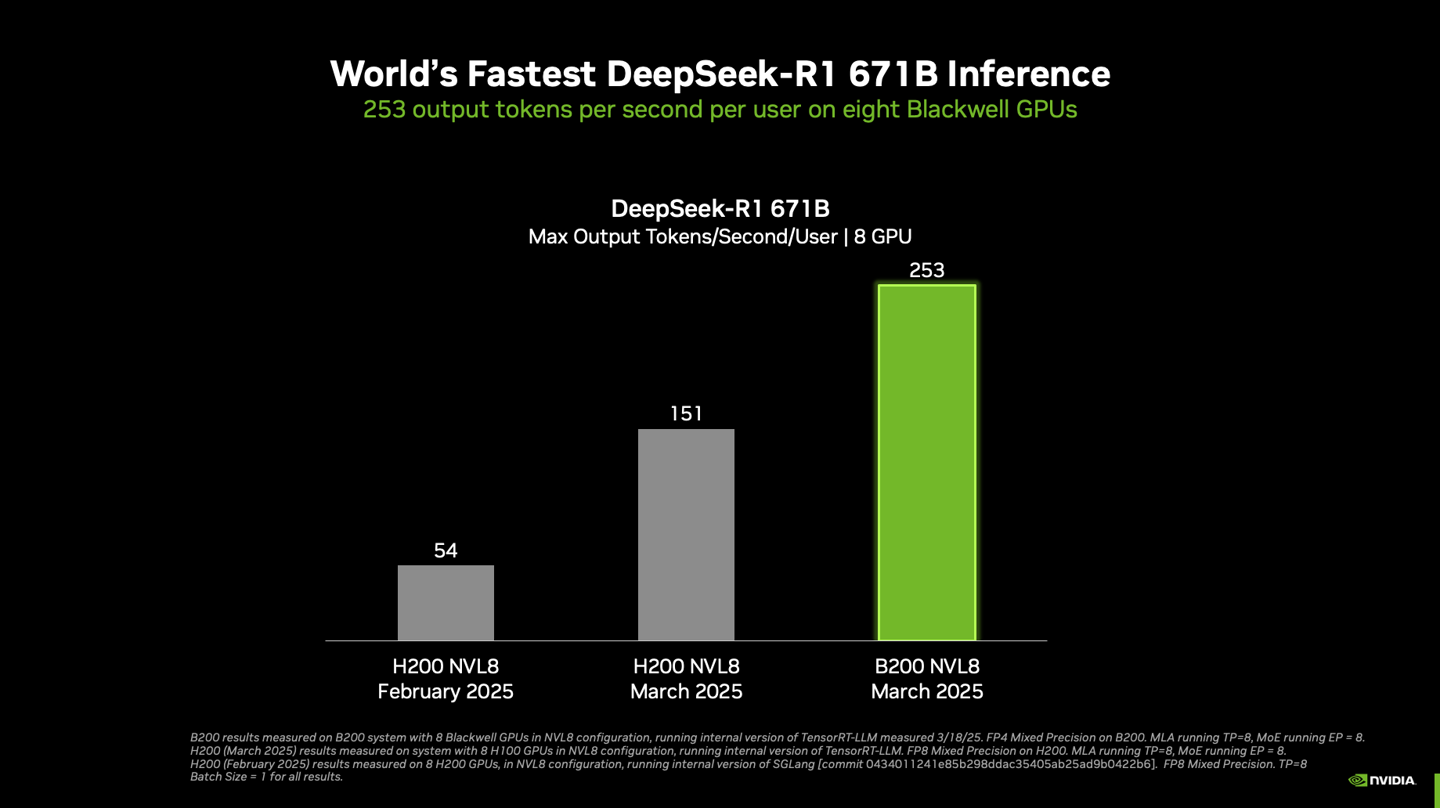

據介紹,在搭載了八塊 Blackwell GPU 的單個 DGX 系統上運行 6710 億參數的滿血 DeepSeek-R1 模型可實現每用戶每秒超 250 token 的響應速度,系統最高吞吐量突破每秒 3 萬 token。

英偉達表示,隨著 NVIDIA 平臺繼續在最新的 Blackwell Ultra GPU 和 Blackwell GPU 上突破推理極限,其性能將會繼續不斷提高。

▲ 運行 TensorRT-LLM 軟件的 NVL8 配置的 NVIDIA B200 GPU

單節點配置:DGX B200(8 塊 GPU)與 DGX H200(8 塊 GPU)

測試參數:最新測試采用 TensorRT-LLM 內部版本,輸入 1024 token / 輸出 2048 token;此前測試為輸入 / 輸出各 1024 token;并發

計算精度:B200 采用 FP4,H200 采用 FP8 精度

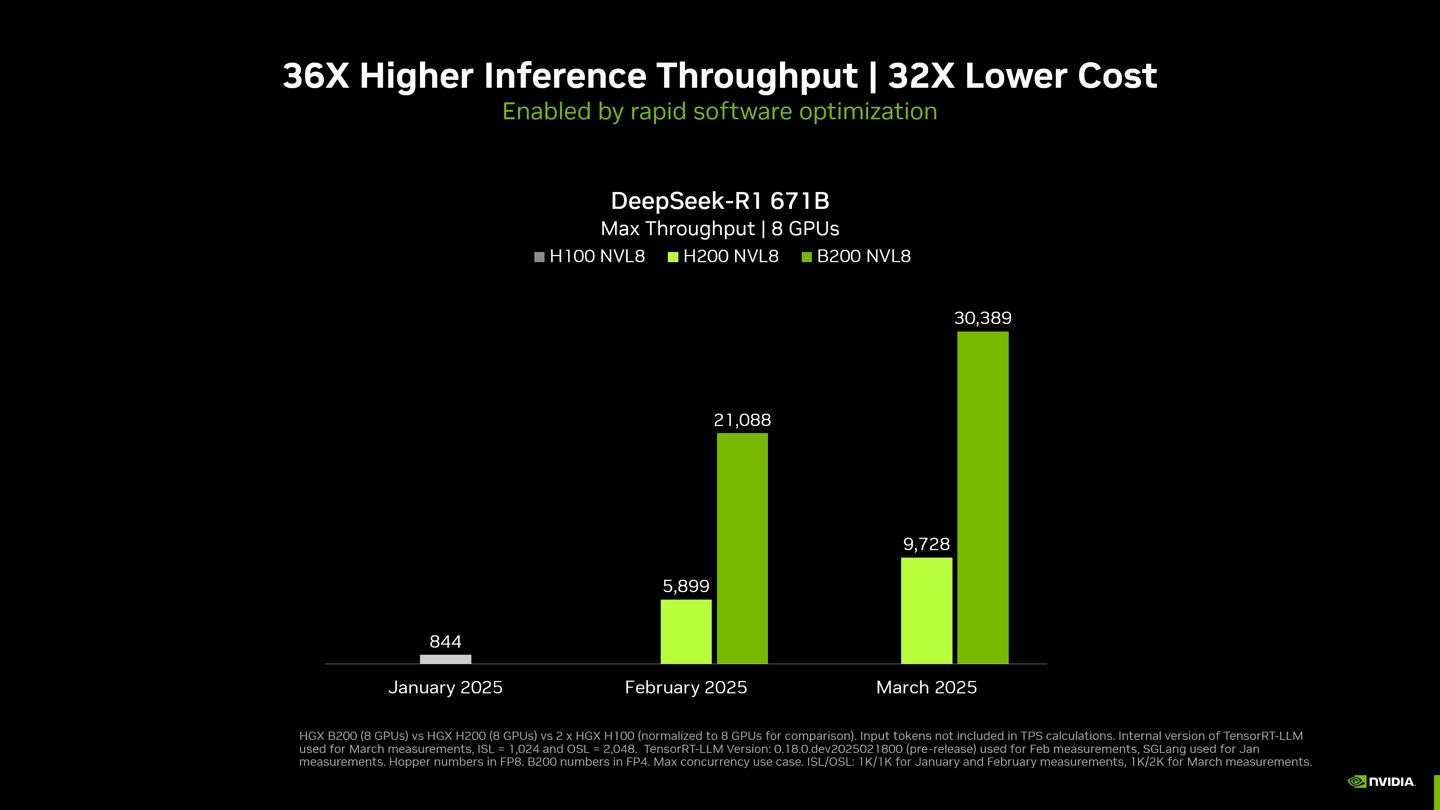

英偉達表示,通過硬件和軟件的結合,他們自 2025 年 1 月以來成功將 DeepSeek-R1 671B 模型的吞吐量提高了約 36 倍。

節點配置:DGX B200(8 塊 GPU)、DGX H200(8 塊 GPU)、兩個 DGX H100(8 塊 GPU)系統

測試參數:依然采用 TensorRT-LLM 內部版本,輸入 1024 token / 輸出 2048 token;此前測試為輸入 / 輸出各 1024 token;并發性 MAX

計算精度:B200 采用 FP4,H100 / H200 采用 FP8 精度

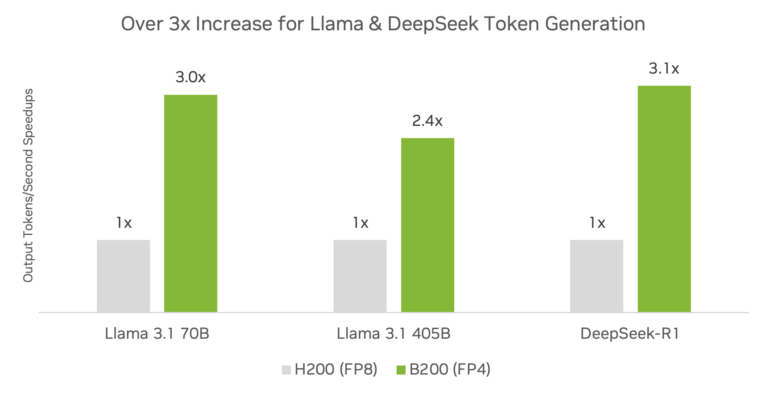

與 Hopper 架構相比,Blackwell 架構與 TensorRT 軟件相結合可實現顯著的推理性能提升。

英偉達表示,包括 DeepSeek-R1、Llama 3.1 405B 和 Llama 3.3 70B,運行 TensorRT 軟件并使用 FP4 精度的 DGX B200 平臺與 DGX H200 平臺相比已經提供了 3 倍以上的推理吞吐量提升。

| 精度 | MMLU | GSM8K | AIME 2024 | GPQA Diamond | MATH-500 |

| DeepSeek R1-FP8 | 90.8% | 96.3% | 80.0% | 69.7% | 95.4% |

| DeepSeek R1-FP4 | 90.7% | 96.1% | 80.0% | 69.2% | 94.2% |

英偉達表示,在對模型進行量化以利用低精度計算優勢時,確保精度損失最小化是生產部署的關鍵。IT之家注意到,在 DeepSeek-R1 模型上,相較于 FP8 基準精度,TensorRT Model Optimizer 的 FP4 訓練后量化(PTQ)技術在不同數據集上僅產生微乎其微的精度損失。