近日,字節跳動正式發布基于以太網極致優化的 GPU Scale-up 互聯技術白皮書,推出 EthLink 的創新網絡方案,旨在為 AI 集群提供低延遲、高帶寬的高速互聯傳輸,滿足 AI 應用對 GPU 之間高效通信的需求。

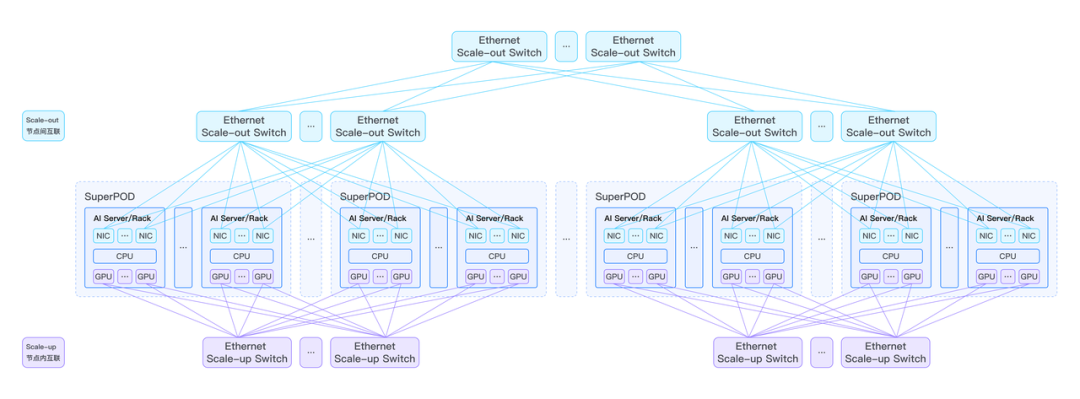

隨著 LLM 的參數規模和算力需求呈指數級增長,構建超大規模的 GPU 集群已成為行業共識。在 GPU 萬卡集群中,存在著 Scale-up 和 Scale-out 兩種互聯域,分別負責節點內和節點間的高效數據傳輸。其中,Scale-up 互聯域尤為關鍵,它要求在單臺服務器和 AI Rack 內實現 8 卡及以上 GPU 的高帶寬、低時延互聯,為模型的張量并行(TP)和專家并行(EP)提供支持。

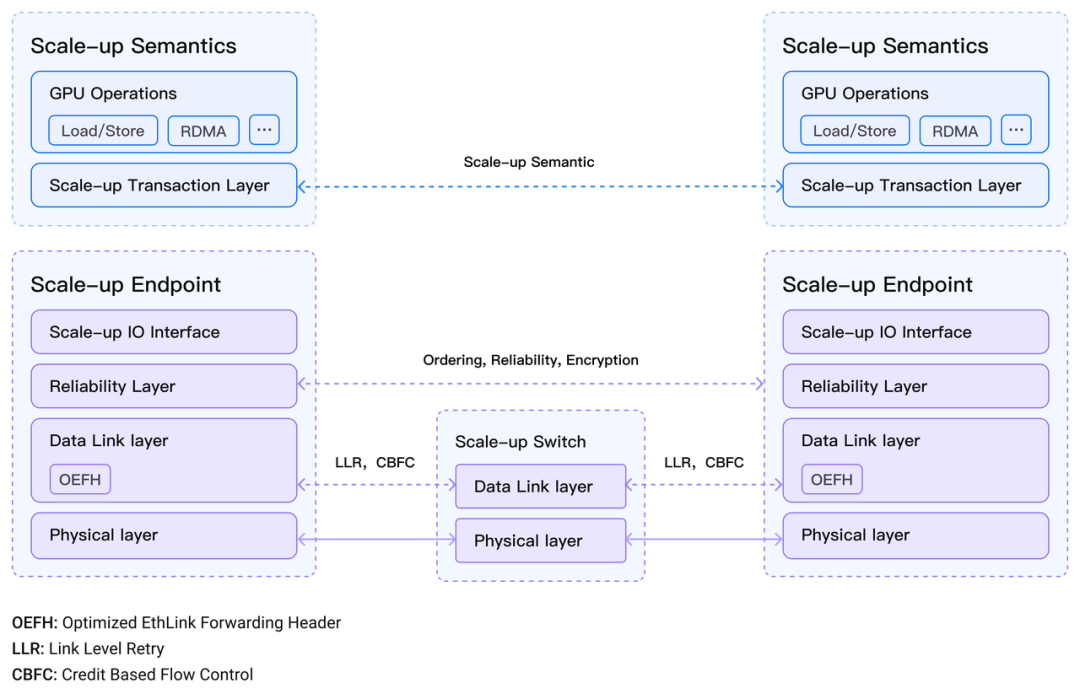

在此背景下,字節跳動提出的 EthLink 方案基于原生以太網進行了極致優化,具備獨特的技術優勢。該方案允許 GPU 通過 Load/Store 內存語義執行同步操作,實現小塊數據的高效傳輸,適用于對數據傳輸時延敏感的應用場景;GPU 還能通過 RDMA 消息語義執行異步操作,完成大塊數據的快速傳輸,滿足帶寬需求大、對時延不敏感的數據應用。

與傳統的 Scale-up 互聯技術相比,以太網在構建 AI 網絡架構方面具有顯著優勢,包括超高速鏈路、超大容量交換機、成熟的生態系統以及易于操作的運維體系。盡管多個行業組織已在 AI 網絡技術開發方面展開探索,但基于以太網極致優化的 AI Scale-up 互聯體系在業界一直處于空白狀態。字節跳動的 EthLink 方案填補了這一空白,為 GPU 超節點提供了全新的高速互聯通道。

展望未來,字節跳動計劃聯合產業合作伙伴,共同構建基于以太網的 Scale-up 網絡生態,進一步完善 EthLink 技術體系。

字節跳動發布的 EthLink 方案及白皮書,將為 AI 行業的發展注入新的活力。隨著相關技術的不斷完善和生態系統的逐步建立,AI 應用的性能和效率將得到進一步提升,為通用人工智能的實現奠定更加堅實的基礎。